martes, 19 de abril de 2011

viernes, 15 de abril de 2011

A Weak Galerkin Finite Element Method for Second-Order Elliptic Problems. (arXiv:1104.2897v1 [math.NA])

In this paper, authors shall introduce a finite element method by using a

weakly defined gradient operator over discontinuous functions with

heterogeneous properties. The use of weak gradients and their approximations

results in a new concept called {\em discrete weak gradients} which is expected

to play important roles in numerical methods for partial differential

equations. This article intends to provide a general framework for operating

differential operators on functions with heterogeneous properties. As a

demonstrative example, the discrete weak gradient operator is employed as a

building block to approximate the solution of a model second order elliptic

problem, in which the classical gradient operator is replaced by the discrete

weak gradient. The resulting numerical approximation is called a weak Galerkin

(WG) finite element solution. It can be seen that the weak Galerkin method

allows the use of totally discontinuous functions in the finite element

procedure. For the second order elliptic problem, an optimal order error

estimate in both a discrete $H^1$ and $L^2$ norms are established for the

corresponding weak Galerkin finite element solutions. A superconvergence is

also observed for the weak Galerkin approximation.

Parallel calculation of the median and order statistics on GPUs with application to robust regression. (arXiv:1104.2732v1 [cs.DC])

We present and compare various approaches to a classical selection problem on

Graphics Processing Units (GPUs). The selection problem consists in selecting

the $k$-th smallest element from an array of size $n$, called $k$-th order

statistic. We focus on calculating the median of a sample, the $n/2$-th order

statistic. We introduce a new method based on minimization of a convex

function, and show its numerical superiority when calculating the order

statistics of very large arrays on GPUs. We outline an application of this

approach to efficient estimation of model parameters in high breakdown robust

regression.

jueves, 14 de abril de 2011

martes, 12 de abril de 2011

Adaptative Step Size Selection for Homotopy Methods to Solve Polynomial Equations. (arXiv:1104.2084v1 [math.NA])

Given a C^1 path of systems of homogeneous polynomial equations f_t, t in

[a,b] and an approximation x_a to a zero zeta_a of the initial system f_a, we

show how to adaptively choose the step size for a Newton based homotopy method

so that we approximate the lifted path (f_t,zeta_t) in the space of (problems,

solutions) pairs.

The total number of Newton iterations is bounded in terms of the length of

the lifted path in the condition metric.

lunes, 11 de abril de 2011

jueves, 7 de abril de 2011

miércoles, 6 de abril de 2011

martes, 5 de abril de 2011

lunes, 4 de abril de 2011

Por qué es difícil descubrir el bosón de Higgs

El bosón de Higgs es una partícula que no se puede observar de forma directa en el LHC del CERN o en el Tevatrón del Fermilab ya que su vida media es demasiado corta para dejar una traza visible: si se produce un Higgs en una colisión se desintegrará tan rápido que lo único que se podrá observar son los resultados de su desintegración (lo mismo le pasa al quark top). Como el bosón de Higgs interactúa con cualquier partícula que tenga masa en reposo no nula, sus productos de desintegración son de una diversidad enorme, lo que dificulta mucho saber si los productos de una desintegración concreta corresponden a una colisión que ha producido un Higgs o a una que no lo ha producido. Me ha gustado mucho el post de Flip Tanedo, “An Idiosyncratic Introduction to the Higgs,” US LHC Blog, 25 Mar 2011. Te recomiendo su lectura. Va directo al grano, los diagramas de Feynman que involucran al Higgs. Para los que no lean bien en inglés presentaré un resumen.

Las partículas elementales en el modelo estándar son de dos tipos: partículas de materia (fermiones), que se representan en un diagrama de Feynman con líneas continuas y flechas, y las partículas transmisoras de una interacción (bosones gauge), que se representan como líneas onduladas. El bosón de Higgs es un bosón, pero un bosón escalar, lo que le hace diferente a los otros bosones gauge como el fotón, los bosones W y Z, y los gluones que son bosones vectoriales. ¿Cuál es la diferencia entre ser escalar y ser vectorial? La diferencia más obvia es en el comportamiento de la partícula ante rotaciones (de la partícula o de los ejes de coordenadas). Un bosón vectorial es como una partícula puntual con una flecha: hay que girar la partícula 360 grados para que no cambie su estado. Sin embargo, un bosón escalar es como una partícula puntual sin flecha: la partícula se puede girar cualquier ángulo sin que cambie su estado. Por cierto, para los fermiones un giro de 360 grados no recupera el estado original, es necesario un giro de 720 grados para lograrlo.

En un diagrama de Feynman el bosón de Higgs se representa por una línea discontinua (la “h” no es necesaria):

En un diagrama de Feynman la interacción entre varias partículas se representa mediante un vértice en el que coinciden estas partículas. El bosón de Higgs del modelo estándar mínimo es una partícula neutra (para la carga eléctrica y para la carga de color) por lo que se puede desintegrar en un par de partículas cuya suma total de carga sea nula. Por ello un bosón de Higgs puede desintegrarse en un par de fermiones (ff o fermión-antifermión) o en un par de bosones gauge (XX, ambos neutros o de cargas opuestas).

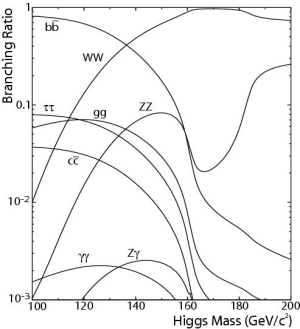

La desintegración más probable del Higgs en dos fermiones es en un par quark-antiquark (qq), aunque también puede hacerlo en un par leptón-antileptón (ll), por ejemplo, un par electrón-positrón (ee). El acoplamiento del Higgs con los fermiones depende de la masa del fermión por lo que las desintegraciones más probables son las conducen a dos fermiones pesados: un par de quarks bottom-antibottom (bb), un par de quarks charm-anticharm (cc) y un par tauón-antitauón (ττ); para que el Higgs se pudiera desintegrar en un par de quarks top-antitop (tt) tendría que tener una masa mayor que el doble de la del quark top, o sea mayor de 346 GeV/c² (hoy en día se prefiere un Higgs mucho más ligero). La probabilidad de cada una de estas desintegraciones depende de la masa del Higgs y puede ser calculada utilizando el modelo estándar; la siguiente figura muestra curvas con el resultado.

La desintegración del Higgs en dos bosones gauge también depende de su masa. Como muestra la figura de arriba, el Higgs se puede desintegrar en un par de gluones (gg), un par de bosones vectoriales débiles (WW o ZZ), un par fotones (γγ), y un fotón y un Z (Zγ). La figura muestra en su eje vertical el Branching Ratio que es la probabilidad para cada canal de desintegración (la suma de las probabilidades de desintegración de todos los canales totaliza la unidad). Para un Higgs con una masa de 120 GeV/c² lo más probable es la desintegración bb, seguida de WW, gg, ττ, cc, ZZ, γγ y Zγ (esta última es cuatro órdenes de magnitud más pequeña que la primera). Ejercicio: cuáles son las desintegraciones más probables de un Higgs con una masa de 160 GeV/c².

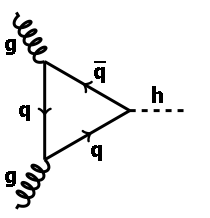

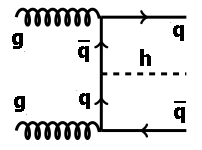

En el LHC del CERN se busca la producción de un Higgs en la colisión de dos protones (en el Tevatrón del Fermilab se colisionan un protón y un antiprotón). Los protones no son partículas elementales, están compuestas de quarks, antiquarks y gluones. Hay tres quarks de valencia rodeados de un gran número de partículas virtuales, tanto gluones virtuales como pares quark-antiquark virtuales, que aparecen y desaparecen de forma constante. Los bosones de Higgs son producidos por las colisiones de partículas virtuales, una de un protón y otra del otro protón. El canal principal de producción de un Higgs en el LHC es la fusión de dos gluones virtuales, aunque la producción directa gg→h no es posible (el gluón no tiene masa en reposo), tiene que estar mediada por quarks, como muestra el siguiente diagrama de Feynman (el quark q se puede cambiar por un antiquark):

Este diagrama (gg→h) presenta un bucle cerrado de quarks en su centro. Un gluón de un protón se desintegra en un par quark-antiquark; el quark (o el antiquark) colisiona con un gluón del otro protón que lo desvía de tal forma que choca contra el antiquark (o el quark) original produciendo un bosón de Higgs. No hay que pensar mucho para darse cuenta de que la probabilidad de este diagrama es baja (es un diagrama complicado). Como el quark top es el más masivo, la producción de un Higgs por este diagrama es más probable cuando los quarks virtuales son quarks top, por lo que este diagrama es mucho más probable en el LHC (colisiones a 7000 GeV c.m.) que en el Tevatrón (colisiones a 1960 GeV c.m.).

Otra forma de producir un Higss es mediante la producción de cuatro quarks top (dos pares top-antitop) virtuales, como muestra el siguiente diagrama de Feynman:

En este diagrama de producción del Higgs (gg→tth), además del Higgs aparecen como productos de la colisión un quark top y un antiquark top (o quark antitop), por ello, aunque el diagrama parece más sencillo tiene una menor probabilidad que el anterior.

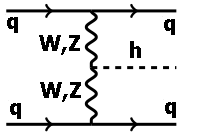

La producción del Higgs también se da en la interacción débil entre dos quarks virtuales (uno de cada protón) a través de un par de bosones vectoriales (ambos W de carga opuesta o ambos Z, que son neutros); cuando ambos bosones vectoriales colisionan se produce un Higgs según el siguiente diagrama de Feynman:

Este diagrama (qq→qqh) se conoce como fusión vectorial porque son los bosones vectoriales W o Z virtuales los producen el Higgs.

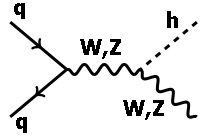

También se produce un Higgs asociado a la de bosones vectoriales W o Z , según el siguiente diagrama de Feynman, en el que la colisión de un par quark-antiquark produce un bosón vectorial que emite un Higgs:

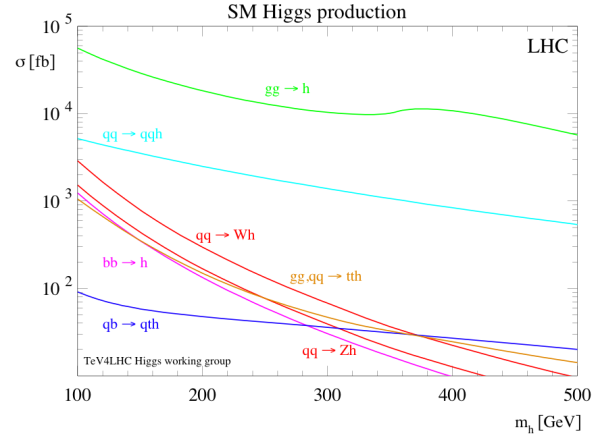

Aunque otras maneras de producir un Higgs en una colisión protón-protón, los cuatro diagramas anteriores son los procesos dominantes. La probabilidad de producir un Higgs por todos estos canales depende de su masa. La figura siguiente muestra las secciones eficaciones de producción (básicamente la probabilidad de producción) del bosón de Higgs en el LHC a partir de los diagramas anteriores y alguno más:

El eje vertical de la figura de arriba es la sección eficaz medida en femtobarns (fb) y permite calcular el número de bosones de Higgs producidos tras estudiar cierto número de colisiones (que se mide en inversos de femtobarn, 1/fb), la luminosidad integrada. Para el bosón de Higgs del modelo estándar el mecanismo de producción dominante en el LHC es la fusión de gluones gg→h.

¿Por qué es difícil observar el Higgs en las colisiones del LHC? El mayor problema es que los modos de producción y desintegración del Higgs producen trazas similares a muchos otros procesos que no muestran un Higgs (que en la búsqueda del Higgs se llaman procesos de “fondo” o background). Por ejemplo, la producción de Higgs por la fusión de dos gluones, acompañada de dos quarks top, resulta en la siguiente desintegración

gg → tth → blν blν bb

donde el quark (antiquark) top decae en un un quark (antiquark) bottom, un leptón y un neutrino, y el Higgs decae en un par quark-antiquark bottom. ¿Cómo se observan estos cuatro quarks bottom en los experimentos? Como estos quarks son pesados y pueden decaer en muchas otras partículas con menos masa, se produce una cadena de desintegraciones con un gran número de partículas producidas todas en cierto cono (ángulo sólido) que se denomina chorro (hadrónico). Por ello, el proceso anterior conduce a la observación de cuatro chorros de partículas, dos leptones y dos pérdidas de energía (los neutrinos no se observan directamente en el LHC). Un proceso muy complicado de analizar que se complica aún más porque cuando los leptones pesados (tauones) también pueden producir un chorro (leptónico). El resultado es que la colisión de dos gluones produce un Higgs y un par quark-antiquark top pero observamos en los experimentos las trazas de unas 100 partículas que se mueven prácticamente en todas las direcciones. Esto sería sencillo si no fuera porque muchos otras colisiones sin Higgs pueden producir cuatro chorros hadrónicos cuyas trazas en los detectores son muy parecidas a las del Higgs. La relación señal/ruido (S/N) en la producción del Higgs es muy mala y requiere acumular un enorme número de colisiones candidatas antes de que se pueda proclamar una observación fiable de esta esquiva partícula.

El descubrimiento del Higgs requerirá varios años en el LHC del CERN ya que hay que esperar que se acumule un número suficientemente alto de colisiones. Lo más razonable es que se proclame su descubrimiento o casi descubrimiento durante la primavera o el verano de 2013 (todo depende del número total de colisiones que logre acumular el LHC este año y el próximo.

Las desintegraciones más “limpias” (o con mejor relación S/N) son poco probables, como la desintegración en un par de fotones (h→γγ), proceso que no ocurre directamente (pues los fotones no tienen masa) sino a través de quarks virtuales. Este proceso es muy poco frecuente, pero su señal es muy clara y distintiva (la relación S/N es muy buena). Por ello este modo de desintegración es uno de los más prometedores (pero sólo si el Higgs tiene una masa baja, inferior a 130 GeV/c²). El problema ahora mismo es que este modo de desintegración requiere analizar un enorme número colisiones porque es muy poco probable (como muestran la figura de más arriba).

En los experimentos ATLAS y CMS del LHC, así como en CDF y DZero del Tevatrón, se está buscando al bosón de Higgs en prácticamente todos los canales de producción/desintegración posibles. Algunos canales son más prometedores que otros, por ejemplo, Julien Baglio y Abdelhak Djouadi, “Implications of the ATLAS and CMS searches in the channel pp→Higgs→ττ for the MSSM and SM Higgs bosons,” ArXiv, 31 Mar 2011, proponen que el canal gg→h→ττ podría permitir el descubrimiento de un Higss en el rango de masas 115-135 GeV/c² con unos pocos inversos de femtobarn de colisiones (es decir, que podría darse el milagro de un descubrimiento del Higgs durante el año 2012). En mi opinión, estos autores tildan de optimistas.

En resumen, descubrir el bosón de Higgs es difícil porque se acopla a todas las partículas con masa y gracias a ello se sabe esconder muy bien (con una relación señal/ruido muy mala). Pero lo que hay que tener claro es que el LHC del CERN en los próximos años (con buena suerte en 2013, pero con mala suerte en 2016) acabará siendo descubierto.

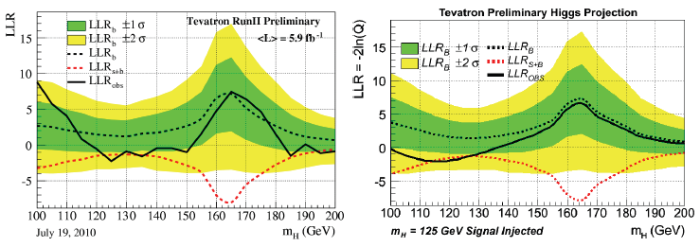

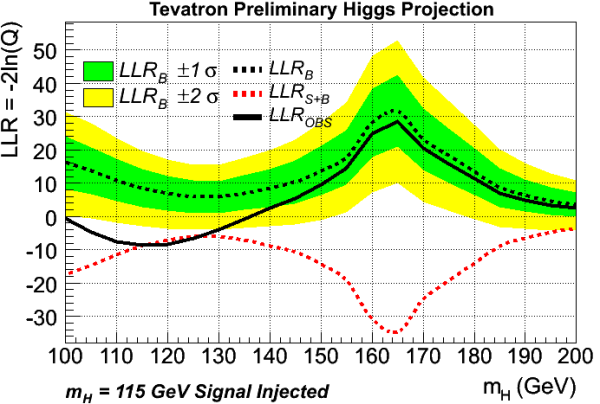

PS (04 abr. 2011): Me ha preguntado un amigo tomando un café lo siguiente (más o menos): Si existiera un bosón de Higgs, cómo cambiarían las figuras con “bandera brasileña” sobre la búsqueda del Higgs. Le he dicho que incorporaría una figura que ví hace poco. Abajo a la izquierda tenéis la figura experimental del Tevatrón a fecha de 19 de julio de 2010 para un bosón de Higgs de baja masa y a la derecha tenéis la figura teórica que se esperaría obtener si se “inyecta” un bosón de Higgs de 125 GeV/c². Como podéis comprobar ambas figuras son compatibles entre sí, es decir, los resultados del Tevatrón son consistentes con la existencia de un Higgs con dicha masa. La figura está extraída de la charla de Michael Cooke (On behalf of the CDF and DZero Collaborations), “Searches for Low-mass SM Higgs at the Tevatron,” 46th Rencontres de Moriond (QCD), March 21, 2011.

Más abajo tenéis también la figura con incluye la inyección de un Higgs con una masa de 115 GeV/c² también extraída de la charla de Michael Cooke (cuyas transparencias recomiendo a todos los interesados en más detalles).

Filed under: Ciencia

domingo, 3 de abril de 2011

A nonlinear PDE-based method for sparse deconvolution. (arXiv:1104.0240v1 [math.OC])

In this paper, we introduce a new nonlinear evolution partial differential

equation for sparse deconvolution problems. The proposed PDE has the form of

continuity equation that arises in various research areas, e.g. fluid dynamics

and optimal transportation, and thus has some interesting physical and

geometric interpretations. The underlying optimization model that we consider

is the standard $\ell_1$ minimization with linear equality constraints, i.e.

$\min_u\{\|u\|_1 : Au=f\}$ with $A$ being an under-sampled convolution

operator. We show that our PDE preserves the $\ell_1$ norm while lowering the

residual $\|Au-f\|_2$. More importantly the solution of the PDE becomes sparser

asymptotically, which is illustrated numerically. Therefore, it can be treated

as a natural and helpful plug-in to some algorithms for $\ell_1$ minimization

problems, e.g. Bregman iterative methods introduced for sparse reconstruction

problems in [W. Yin, S. Osher, D. Goldfarb, and J. Darbon,SIAM J. Imaging Sci.,

1 (2008), pp. 143-168]. Numerical experiments show great improvements in terms

of both convergence speed and reconstruction quality.

Optimisations for quadrature representations of finite element tensors through automated code generation. (arXiv:1104.0199v1 [cs.MS])

We examine aspects of the computation of finite element matrices and vectors

which are made possible by automated code generation. Given a variational form

in a syntax which resembles standard mathematical notation, the low-level

computer code for building finite element tensors, typically matrices, vectors

and scalars, can be generated automatically via a form compiler. In particular,

the generation of code for computing finite element matrices using a quadrature

approach is addressed. For quadrature representations, a number of optimisation

strategies which are made possible by automated code generation are presented.

The relative performance of two different automatically generated

representations of finite element matrices is examined, with a particular

emphasis on complicated variational forms. It is shown that approaches which

perform best for simple forms are not tractable for more complicated problems

in terms of run time performance, the time required to generate the code or the

size of the generated code. The approach and optimisations elaborated here are

effective for a range of variational forms.

sábado, 2 de abril de 2011

viernes, 1 de abril de 2011

jueves, 31 de marzo de 2011

miércoles, 30 de marzo de 2011

martes, 29 de marzo de 2011

viernes, 25 de marzo de 2011

jueves, 24 de marzo de 2011

miércoles, 23 de marzo de 2011

lunes, 21 de marzo de 2011

viernes, 18 de marzo de 2011

jueves, 17 de marzo de 2011

Data sets of very large linear feasibility problems solved by projection methods. (arXiv:1103.2952v1 [cs.MS])

We give a link to a page on the Web on which we deposited a set of eight huge

Linear Programming (LP) problems for Intensity-Modulated Proton Therapy (IMPT)

treatment planning. These huge LP problems were employed in our recent research

and we were asked to make them public.

sin[n Delta t sin (n Delta t1)] as a source of unpredictable dynamics. (arXiv:1103.3160v1 [nlin.CD])

We investigate the ability of the function sin[n Delta t sin (n Delta t1)],

where n is an integer and growing number, to produce unpredictable sequences of

numbers. Classical mathematical tools for distinguishing periodic from chaotic

or random behaviour, such as sensitivity to the initial conditions, Fourier

analysis, and autocorrelation are used. Moreover, the function acos{sin[n Delta

t sin (n Delta t1)]}/pigreek is introduced to have an uniform density of

numbers in the interval [0,1], so it can be submitted to a battery of widely

used tests for random number generators. All these tools show that a proper

choice of Delta t and Delta t1, can produce a sequence of numbers behaving as

unpredictable dynamics.

PyDEC: Software and Algorithms for Discretization of Exterior Calculus. (arXiv:1103.3076v1 [cs.NA])

This paper describes the algorithms, features and implementation of PyDEC, a

Python library for computations related to the Discretization of Exterior

Calculus (DEC). PyDEC facilitates inquiry into both physical problems on

manifolds as well as purely topological problems on abstract complexes. We

describe efficient algorithms for constructing the operators and objects that

arise in DEC and related topological problems. Our algorithms are formulated in

terms of high-level matrix operations which extend to arbitrary dimension. As a

result, our implementations map well to the facilities of numerical libraries

such as NumPy and SciPy. The availability of such libraries makes Python

suitable for prototyping numerical methods. We demonstrate how PyDEC is used to

solve physical and topological problems through several concise examples.

A study of the existing linear algebra libraries that you can use from C++ (Une \'etude des biblioth\`eques d'alg\`ebre lin\'eaire utilisables en C++). (arXiv:1103.3020v1 [cs.MS])

A study of the existing linear algebra libraries that you can use from C++

Quantum algorithm for the Boolean hidden shift problem. (arXiv:1103.3017v1 [quant-ph])

The hidden shift problem is a natural place to look for new separations

between classical and quantum models of computation. One advantage of this

problem is its flexibility, since it can be defined for a whole range of

functions and a whole range of underlying groups. In a way, this distinguishes

it from the hidden subgroup problem where more stringent requirements about the

existence of a periodic subgroup have to be made. And yet, the hidden shift

problem proves to be rich enough to capture interesting features of problems of

algebraic, geometric, and combinatorial flavor. We present a quantum algorithm

to identify the hidden shift for any Boolean function. Using Fourier analysis

for Boolean functions we relate the time and query complexity of the algorithm

to an intrinsic property of the function, namely its minimum influence. We show

that for randomly chosen functions the time complexity of the algorithm is

polynomial. Based on this we show an average case exponential separation

between classical and quantum time complexity. A perhaps interesting aspect of

this work is that, while the extremal case of the Boolean hidden shift problem

over so-called bent functions can be reduced to a hidden subgroup problem over

an abelian group, the more general case studied here does not seem to allow

such a reduction.

miércoles, 16 de marzo de 2011

domingo, 13 de marzo de 2011

sábado, 12 de marzo de 2011

II Carnaval de Biología: Hacia los orgánulos celulares artificiales fabricados con polímeros

Imagina un futuro en el que los médicos introducirán orgánulos artificiales en ciertas células de tu cuerpo capaces de producir medicamentos cuando la célula lo requiera. Ese futuro es aún lejano, pero Shum et al. han publicado en la revista Angewandte Chemie el primer paso hacia la incorporación de orgánulos artificiales en una célula, la fabricación de una jerarquía de cápsulas anidadas cuyas paredes están formadas por pequeños polímeros capaces de almacenar agua en su interior. El siguiente paso será demostrar que estas cápsulas son capaces de atravesar la pared celular e incorporarse al interior de una célula viva como un elemento más de ella. Podría parecer lejano este momento, pero según nos cuentan Takamasa Harada y Dennis E. Discher, “Materials science: Bubble wrap of cell-like aggregates,” Nature 471: 172–173, 10 March 2011, quizás no esté tan lejos. Se han hecho eco del artículo técnico de H. C. Shum, Y.-J. Zhao, S.-H. Kim, and D. A. Weitz, “Multicompartment polymersomes from double emulsions,” Angewandte Chemie International Edition 50: 1648-1651, 2011 [gratis en la web]. Esta entrada participa en la II Edición del Carnaval de Biología, que se celebra durante este mes en el blog La muerte de un ácaro.

Los autores del artículo han utilizado técnicas de formación de burbujas utilizando microfluidos gracias a emulsiones dobles agua-aceite-agua (W/O/W o water-in-oil-in-water). El resultado son gotas de agua rodeadas por aceite que a su vez nadan en una solución de acuosa. El nuevo artículo también ha logrado vesículas multicompartimento que pueden almacenar substancias con una actividad diferente en su interior (tanto múltiples gotas unas dentro de otras, como gotas pegadas a otras cara con cara); la figura de abajo ilustra estas estructuras que recuerdan a pompas de jabón pegadas unas a otras.

La clave del logro alcanzado está en los ingredientes utilizados para fabricar el aceite, una mezcla de cloroformo y hexano, y las propiedades del copolímero utilizado (un copolímero es un polímero formado por uno o más cadenas de polímeros de diferente composición química que están conectados entre sí). La solubilidad de este copolímero es mayor en uno de los solventes (cloroformo) que en el otro (hexano). Además, su carácter anfifílico (posee dos cadenas poliméricas, una hidrofóbica y otra hidrofílica) hace que forme membranas; estas membranas se cierran encapsulando una gota de agua cuando el cloroformo (que es volátil) se evapora. Como la solubilidad del copolímero en el hexano restante es más baja que en la mezcla cloroformo-hexano original, estas gotas de agua encapsuladas pueden pegarse las unas a las otras y formar cápsulas dobles. El “pegamento” de estas burbujas dobles es bastante fuerte, según los autores.

El copolímero utilizado por los autores es biocompatible (PEG-b-PLA) y está aprobado por la Administración de EE.UU. (US Food and Drug Administration) para su uso como contenedor de medicamentos. De hecho, el PEG-b-PLA ya ha sido utilizado para la dosificación de terapias basadas en ácidos nucléicos (ARN de interferencia o oligonucleótidos antisentido) tanto a nivel celular como en animales vivos de laboratorio. Por supuesto, todavía quedan muchos problemas por resolver pero el logro de Shum et al. estimulará a muchos grupos de investigación en el desarrollo de aplicaciones biomédicas de estos orgánulos celulares artificiales.

Filed under: Biología, Ciencia, Medicina, Science Tagged: Biología, curiosidades, experimento, Medicina, Noticias

Simulación de la NOAA para la propagación del tsunami de Honshu en el Océano Pacífico

Japón es un archipiélago cuyas cuatro islas más grandes son Hokkaidō, Honshu, Kyushu, y Shikoku. La segunda de ellas, Honshu ha sido la más afectada por el tsunami generado por el terromoto de grado 8’9 en la escala de Richter cuyo epicentro se ha situado en las coordenadas 38.322°N, 142.369°E, a las 05:46 UTC. Aproximadamente a unos 130 km al este de la ciudad de Sendai (la más dañada). Unos 25 minutos más tarde, el tsunami generado por el terremoto fue detectado por las boyas oceánicas DART®, en concreto por la boya 21418. La simulación que ha permitido obtener el vídeo que abre esta entrada ha sido desarrollada por la NOAA (National Oceanic and Atmospheric Administration) a partir de las medidas de cuatro boyas oceánicas (mostradas como puntos amarillos cercanos a Japón). Más información en inglés en “Tsunami Event - March 11, 2011 Honshu,” NOAA Main Event Page. El vídeo se puede descargar en formato .mov en mejor resolución aquí.

Supongo que estarás harto de leer información sobre el tsunami de Japón por doquier. Si aún te quedan fuerzas para leer algo más, en este blog te recomiendo “¿Interesado en tsunamis? Algunos enlaces de interés,” 31 enero 2008; y ““El tsunami de 2004 en Sumatra no fue de tipo solitón” gana el premio al mejor artículo en física de fluidos de 2008,” 7 abril 2009. Y por cierto, más información sobre el desastre en la wikipedia: “Terremoto y tsunami de Japón de 2011.”

¿Por qué es difícil predecir el próximo gran terremoto? Los sismógrafos modernos son muy sensibles y son capaces de calcular el lugar exacto donde se ha producido un terremoto, así como su magnitud. Sin embargo, los científicos aún son incapaces de predecir cuándo y dónde se producirá el próximo gran terremoto. Se ha avanzado mucho desde que Alfred Wegener propuso en 1915 la teoría de la tectónica de placas (que no fue aceptada hasta la década de 1960), la teoría que explica por qué se producen los terremotos. Sin embargo, ni la tecnología actual ni las teorías sismológicas más avanzadas pueden predecir el próximo gran terremoto. EE.UU., China y Japón tienen a cientos de científicos estudiando el problema, que aún se nos escapa. El método de pronóstico más estudiado se centra en los temblores de menor importancia que a menudo anuncian un terremoto de gran tamaño. Por desgracia, este método es propenso a las falsas alarmas, porque la gran mayoría de los temblores de menor importancia no son seguidos por otros mayores. Además, muchos grandes terremotos no fueron precedidos por temblores más pequeños. China predijo con éxito en 1975 un gran terremoto (7’3 grados) y logró evacuar a las personas en sus proximidades, pero en los últimos 20 años, ha emitido más de 30 falsas alarmas y no fueron capaces de predecir el terremoto de 2008 que devastó el este de Sichuán. Los científicos del USGS de EE.UU. también predijeron en 1985 un próximo gran terremoto en Parkfield, California, provocado por la famosa falla de San Andrés (desde 1850 esta zona había sufrido un terremoto de magnitud 6 o superior cada 22 años en promedio). Se estimó con una probabilidad del 95 por ciento que un terremoto de magnitud 6 o mayor sucedería en 1993. Pero el siguiente gran terremoto en Parkfield ocurrió en 2004, 11 años después del período de predicción inicial. Hay muchos métodos de predicción de terremotos propuestos, pero la verdad es que todavía la sismología está muy lejos de poder predecir a corto plazo el próximo gran terremoto. Nos lo ha contado John Horgan, “Japan earthquake demonstrates the limits—and power—of science,” Scientific American, Mar 11, 2011.

Filed under: Ciencia, Noticias, Physics, Science Tagged: Ciencia, Física, física computacional, Noticias, simulación, tsunami

viernes, 11 de marzo de 2011

miércoles, 9 de marzo de 2011

jueves, 3 de marzo de 2011

Simulaciones por ordenador descubren la causa de la disminución de manchas solares en el último ciclo solar

El número de manchas solares observadas en la superficie del Sol varía de forma periódica, pasando por máximos y mínimos sucesivos. Tras el último ciclo solar, el 23, el Sol entró en un mínimo prolongado caracterizado por un campo polar magnético muy débil y gran número de días sin manchas solares. Las manchas solares son regiones fuertemente magnetizadas generadas por un mecanismo de dinamo que recrea campos magnéticos polares a través de los flujos de plasma hacia la superficie solar. Nandy et al. han desarrollado simulaciones por ordenador que demuestran que un flujo meridional rápido en la primera mitad de un ciclo, seguido por un flujo más lento en la segunda mitad, reproduce las características del mínimo de manchas solares en el ciclo 23, llegando a la conclusión de que los mínimos muy profundos están asociados con campos polares débiles. El artículo técnico es Dibyendu Nandy, Andrés Muñoz-Jaramillo, Petrus C. H. Martens, “The unusual minimum of sunspot cycle 23 caused by meridional plasma flow variations,” Nature 471: 80–82, 03 March 2011. Más información divulgativa en español en Jesús Cobas, “Resuelto el misterioso caso de la disminución de manchas solares,” Jesús Cobas, 02 marzo 2011, que ha traducido a Charles Q. Choi, “Mysterious Case of Missing Sunspots Solved,” SPACE.com, 02 March 2011. Y también en

Las observaciones telescópicas pioneras de Galileo Galilei y de Christopher Scheiner en el siglo XVII iniciaron la observación y contaje de las manchas solares. Unos 400 años de de observación han mostrado que sólo en el período 1645-1715 dC, conocido como el mínimo de Maunder, cuando casi no se observaron manchas solares, la serie temporal de las manchas solares muestra una variación cíclica pasando por épocas sucesivas de máxima y mínima actividad. El nuevo artículo ha desarrollado un nuevo modelo de la dinámica solar que resuelve las ecuaciones de evolución para las componentes toroidal y poloidal del campo magnético solar (escritas en la figura) con las que han estudiado más de 210 ciclos solares correspondientes a 1.860 años. Estas simulaciones estudian el efecto del cambio de los flujos meridionales mediante la introducción de fluctuaciones en el flujo meridional.

En la gráfica inferior izquierda de la figura, vn es la velocidad del flujo durante el mínimo de manchas solares del ciclo n, vn−1 es la velocidad durante la parte más temprana del ciclo, donde el númeor de manchas está creciendo, y vn−vn−1 denota el cambio en la velocidad de flujo entre las partes del ciclo donde el número de manchas cae y crece durante un ciclo. Los autores han observado una buena correlación entre la fuerza del campo polar y la diferencia vn−vn−1 con un coeficiente de correlación r = 0’87 con probabilidad P = 99’99%. La conclusión es que un cambio del flujo meridional interno de rápido a lento resulta en mínimos solares profundos. Los resultados del modelo son robustos con respecto a cambios razonables en la parámetros del sistema.

Estos resultados obtenidos gracias a simulaciones por ordenador deberán ser confirmados por los experimentos. Los autores esperan que el Observatorio de Dinámica Solar (SDO) de la NASA proporcionará datos más precisos sobre la estructura de los flujos de plasma en el interior del Sol que podrán confirmar y/o complementar los resultados de sus simulaciones.

Filed under: Astrofísica, Ciencia, Física, Noticias, Physics, Science Tagged: actividad solar, Astrofísica, Ciencia, Física, MagnetoHidroDinámica, modelo solar, Noticias

miércoles, 2 de marzo de 2011

viernes, 25 de febrero de 2011

jueves, 24 de febrero de 2011

lunes, 21 de febrero de 2011

viernes, 18 de febrero de 2011

jueves, 17 de febrero de 2011

miércoles, 16 de febrero de 2011

martes, 15 de febrero de 2011

Interpolation, projection and hierarchical bases in discontinuous Galerkin methods. (arXiv:1102.3100v1 [math.NA])

The paper presents results on piecewise polynomial approximations of tensor

product type in Sobolev-Slobodecki spaces by various interpolation and

projection techniques, on error estimates for quadrature rules and projection

operators based on hierarchical bases, and on inverse inequalities. The main

focus is directed to applications to discrete conservation laws.

lunes, 14 de febrero de 2011

viernes, 11 de febrero de 2011

miércoles, 9 de febrero de 2011

lunes, 7 de febrero de 2011

viernes, 4 de febrero de 2011

jueves, 3 de febrero de 2011

miércoles, 2 de febrero de 2011

lunes, 31 de enero de 2011

domingo, 30 de enero de 2011

viernes, 28 de enero de 2011

jueves, 27 de enero de 2011

miércoles, 26 de enero de 2011

martes, 25 de enero de 2011

lunes, 24 de enero de 2011

domingo, 23 de enero de 2011

A New Numerical Algorithm for Thermoacoustic and Photoacoustic Tomography with Variable Sound Speed. (arXiv:1101.3729v1 [math.NA])

We present a new algorithm for reconstructing an unknown source in

Thermoacoustic and Photoacoustic Tomography based on the recent advances in

understanding the theoretical nature of the problem. We work with variable

sound speeds that might be also discontinuous across some surface. The latter

problem arises in brain imaging. The new algorithm is based on an explicit

formula in the form of a Neumann series. We present numerical examples with

non-trapping, trapping and piecewise smooth speeds, as well as examples with

data on a part of the boundary. These numerical examples demonstrate the robust

performance of the new algorithm.

A posteriori error estimators suitable for moving finite element methods under anisotropic meshes. (arXiv:1101.3635v1 [math.NA])

In this paper, we give a new type of a posteriori error estimators suitable

for moving finite element methods under anisotropic meshes for general

second-order elliptic problems. The computation of estimators is simple once

corresponding Hessian matrix is recovered. Wonderful efficiency indices are

shown in numerical experiments.

Convergence Analysis of a Class of Massively Parallel Direction Splitting Algorithms for the Navier-Stokes Equations. (arXiv:1101.3587v1 [math.NA])

We provide a convergence analysis for a new fractional time-stepping

technique for the incompressible Navier-Stokes equations based on direction

splitting. This new technique is of linear complexity, unconditionally stable

and convergent, and suitable for massive parallelization.